017:Describeについて

最近はChatGPT、GeminiなどのマルチモーダルなAIモデル(テキストだけでなく、画像や音声等いろいろなフォーマットの入出力に対応したモデル)が登場してきています。

もともとChatGPTなどのLLM系モデルは言語能力が高いので、画像系モデルのSDXL等よりはプロンプト解釈が的確です。なので、狙った服装、狙った構図等、思い通りに画像生成したい場合はマルチモーダルなモデルを使う方が手っ取り早くなってきています。

ただ、マルチモーダルなモデルは今のところクラウド利用しかできないケースが多いので、ローカルでお手軽に出力、というのはもう少し先の話になりそうです。そもそもLLM系モデルは一般的な市販GPUのVRAMには乗り切らないくらいパラメータ数多いですしね…。

そんな時に使えるんじゃないか、というのがこのDescribe機能です。

これは入力した画像からSDXL系のモデルで出力するためのプロンプトを生成してくれるもので、例えばChatGPTで生成した画像に近いものをSDXLから出力させるような使い方ができます。

さっそくやってみましょう。

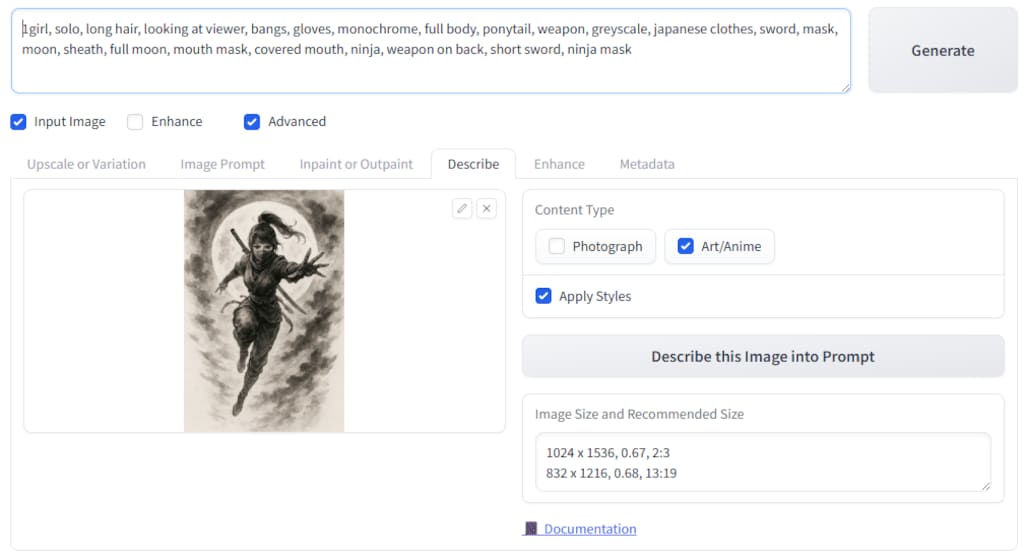

2枚目の画像がChatGPTに出力してもらった画像です。水墨画で、満月を背景にくノ一がジャンプしている、みたいな指示で出力されました。なかなかいいですね。

さてこれをFooocusでDescribeしてみましょう。3枚目の画像のように、「Imput Image」をチェックして、「Describe」タブを開きます。その画像領域に先ほどの画像をセットして、「Content Type」を「Art/Anime」を選択して「Describe this Image into Prompt」のボタンを押すと、プロンプトが生成されます。プロンプト欄に書かれているのが、Describe結果ですね。

さてこのプロンプトを使って早速出力してみましょう。その結果が4枚目です。

なかなかイイ感じなんじゃないでしょうか。

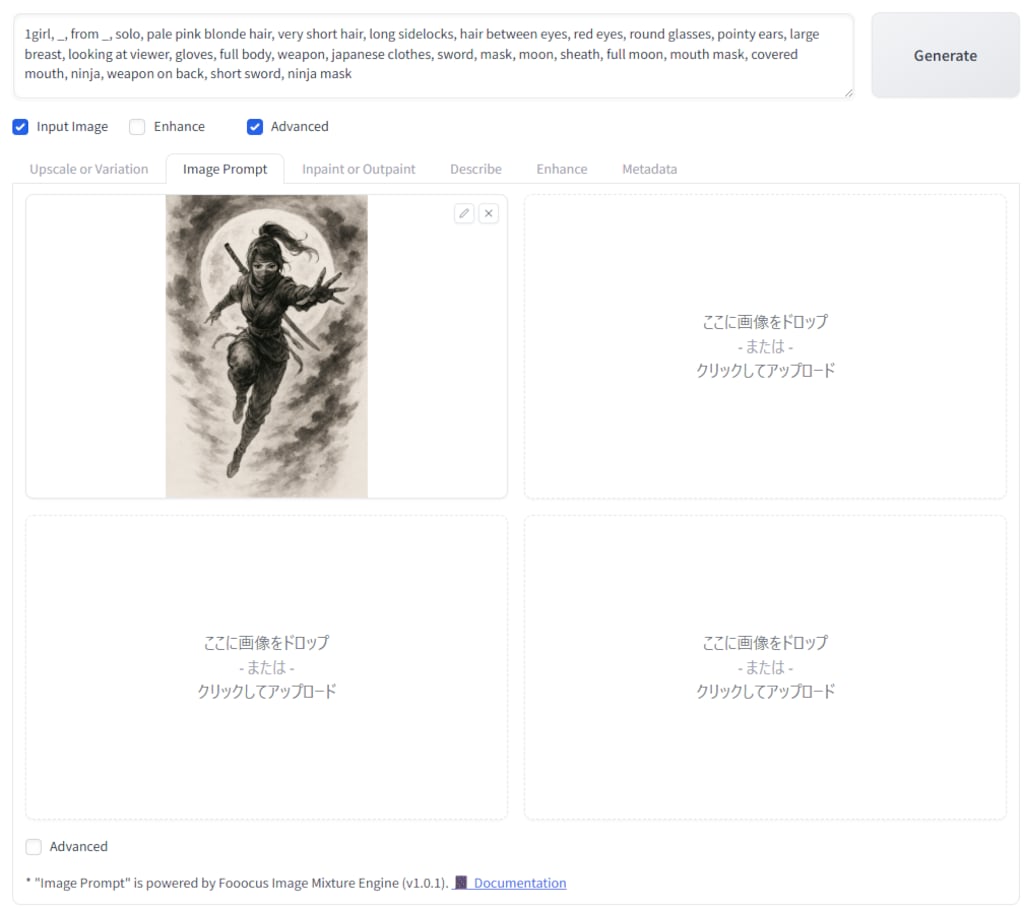

さて、今度はくノ一姉さんをいつものMuaccaさんに差し替えてみましょう。人物フレーズを差し替えて、モノクロではなくカラーで出力するようにプロンプトを変更した結果が5枚目です。

かっこいいですね。

ちなみに今回、Describeする際に「Apply Styles」をチェックしていたので、styleとして「Fooocus V2」と「Fooocus Masterpiece」が適用されていました。これをいつもの絵柄にするために自分のstyleに変更したのが6枚目です。

この状態で、Fooocusの「Image Prompt」(指定した画像も参考にして出力してくれる機能、7枚目画像のようにして指定)も併用して出力したのが1枚目の画像でした。元画像の雰囲気に少し寄る気がしますね。

ちなみに他のi2iも試してみました。

「Vary(Subtle)」で出力したのが8枚目、「Vary(Strong)」で出力したのが9枚目です。

色々な手段があるのは嬉しいですね。

今回のプロンプトは以下の通りです。ご参考まで。

=========================

1girl, _, from _, solo, pale pink blonde hair, very short hair, long sidelocks, hair between eyes, red eyes, round glasses, pointy ears, large breast, looking at viewer, gloves, full body, weapon, japanese clothes, sword, mask, moon, sheath, full moon, mouth mask, covered mouth, ninja, weapon on back, short sword, ninja mask, BREAK masterpiece, best quality, high score, great score, ultra-detailed high resolution (anime-style 3dcg:1.0), intricate details light color, whitish color line art, light diffusion, muted color, Matte flat color, watercolor gradiation, hyper-realistic, Sleek design

6

6

036:Qwen Image Edit の使い方

全体公開

今回は、元画像からテキスト指示で画像を編集できるQwen Image Editを試してみました。 例によって、差分の画像をStart-Endにフレーム指定して動画を作るのに便利、という動機からです。 まずは元画像としていつものようにAnim4gineで画像を用意します(2枚目)。 これを3枚目の画像のようにしてQwen Image Editのワークフローにセットします。 プロンプトとしては、「背景だけをフォトリアルな森の画像に差し替えてください」みたいな自然文をgoogle翻訳で英語にしたものを使ってみました(4枚目)。 今度は4枚目の画像を元にして、「キャラクターを削除して背景だけにしてください」とすると、5枚目のような森の風景だけの画像になりました。消しゴムマジックみたいなことができますね。 さらに「キャラクターを削除するけど、線画だけは残してくれ」としてみたのが6枚目で、そこから「背景を夜にして、線画を光らせてくれ」としたのが1枚目、といった感じです。 nano bananaほど指示がきれいに反映されるというわけではなく、融通が利かないところもあるんですが、これをローカルのPCで使い放題というのは結構楽しいです。 いろいろ試してみたくなりますね。

6

6

035:Anytestの使い方

全体公開

Wan2.2で動画を作るときにはポーズ差分の画像があるとStart-Endでフレーム指定で安定した動画が生成できるので、最近はポーズ差分画像をどう作るかをいろいろ試しています。 nano bananaは強力なのですが、制約があったり絵柄がnano banana絵柄に寄ったりするので他の手段も試している、というか。 私がメインで使っている画像生成モデルはAnimagine4なので、Controlnetでポーズ指定するという手が使えます。 SDXL系のControlnetとしてはAnytestという強力なブツがあるので、それを試してみました。 まずは2枚目のような、大雑把な構図指定画像を手描きします。これはClip Studio Paintでマウスでちょいちょいと5分程度で描いた代物で、「まあなんとなく言いたいことは分かる」レベルのものかな、と思います。 この構図指定画像を参照画像として設定しているのが3枚目の画像で、Anytestを使うためのComfyUIワークフローです。このワークフローで画像を生成したのが1枚目です。なんとなくそれっぽくはなっている気がしますね。 ↓プロンプトはこんな感じにしています。 1girl, _, from _, blonde long hair, blue eyes tareme, forehead, pointy ears large breast, groin tendon slim bod, single-shoulder long magical black robe, bra strap, mini skirt under robe frill skirt, contrapposto, water wave background, smile, (glitter magic circle effect:1.2) from hand, blue water effect, pure clear realistic water, splash water around wind blowing さて、Anytestですが、結構いろいろなことができる「万能Controlnet」と言われていて、例えば4枚目の画像の真ん中の部分を黒塗りでつぶして(5枚目)これを参照画像として渡すと、1枚目の画像のポーズを変更することができたりもします(6枚目)。 1枚目の画像と6枚目の画像を動画のStart-Endフレームに指定すれば、なんとなく水魔法を使っているエルフ姉さんの動画ができるような気がしますね! とまあこんな感じに便利なControlnet「Anytest」ですが、月須和さんがHuggingFaceで公開してくれています。ありがたいですね。 https://huggingface.co/2vXpSwA7

3

3

034:InfiniteTalkで読み上げ動画を作る

全体公開

前回はWan2.2のS2Vモデルを使って、セリフ音声と画像から、読み上げ動画を作りましたが、今回はセリフ音声と動画から、読み上げ動画を作ってみます。 前回のはWan2.2 S2Vで1枚の画像から動画を生成したのですが、口元以外の箇所はあまり動かないというか、ほぼ口パク動画、みたいな感じでした。 今回は人物がなにか動いている動画をもとに、口元をセリフに合わせて口パクさせるというもので、動きのある読み上げ動画を作る場合はこちらの方が良いようです。 こういった手法はVideo to Video(V2V)と呼ばれているようですね。 読み上げのためのV2VにはInfiniteTalkを用いてみました。 InfiniteTalkはまだWan2.2には対応していないので、Wan2.1と組み合わせて使ってみています。 2枚目の画像がInfiniteTalkを使うためのComfyUIのワークフローで、画面下の方で元となる動画(1枚目)を指定しています。 セリフ音声は上の方(音声を読み込む、のところ)に指定してみています。 3枚目もワークフローの一部で、真ん中のあたりにプロンプトを指定しています。この手法の場合、キャラクターの見た目も動きも動画で指定しているので、プロンプトは簡単に「The woman turns to me, stretches her body, and speaks with a smile.」(その女性は私の方を向き、体を伸ばして、笑顔で話します)としました。 あとは実行すると、セリフ音声に合わせて口元の動きが調整されます。

3

3

033:Wan22 S2Vで読み上げ動画を作る

全体公開

今回はWan2.2のS2Vモデルを使って、セリフ音声と画像から、読み上げ動画を作ってみました。 S2Vは、音声からそれに合った動画を生成するものですが、元画像を指定するとそれをもとにI2Vのように画像に沿った動画を生成してくれます。 前回使った魔法少女画像の顔アップ(2枚目)を元画像に指定し、音声として「魔法少女Muacca、いつもみんなと楽しく、ですです」という読み上げ音声を指定してできたのが1枚目の動画です。 残念ながらちちぷいには音声付の動画は投稿できないので、口パクだけになってしまいますが、元画像のキャラがなにかしゃべっている感じになっているのは分かるかと思います。 Wan2.2 S2Vですが、UIとしては公式から配布されているComfyUIワークフローを用いて実行しました(3枚目)。 基本的にはデフォルト値のままで使うのがいいようです。 ちなみに16fpsが指定されているのですが、これを30fpsとかにすると音声と口パクがズレるので、変えないほうが良いようです。fpsを変更したい場合は、生成した動画を別のツールでフレーム補間すればよいと思います。 あと、公式の情報では生成される動画は77フレーム分と書いてあって、これは変更しないほうが良いとのことでした。16fpsだと4秒くらいの動画になるはずなのですが、結果として生成されたのは14秒くらいのものだったので、それがなぜなのかはよくわかりません。投入した音声は4秒くらいだったので、ここに投稿しているものは後ろの無音声部分をカットしてあります。

他のクリエイターの投稿

13

13

ゆるゆるファーストテイク。

580コイン/月以上支援すると見ることができます

ダブルピース

100コイン/月以上支援すると見ることができます

ペンギン🐧✨

500コイン/月以上支援すると見ることができます

31

31

美m010

全体公開

過去作、SD1.5で生成したものをZ-imageでi2iしてみました✨️ ヤバい!可愛すぎる😍😍 v1 美1580 https://www.chichi-pui.com/posts/e11ea262-c172-4c84-abe6-279aa47ea69d/ v2 美1581 https://www.chichi-pui.com/posts/7a4f655f-444f-4af9-a7c4-08b2a1334643/

18

18

漫画風アクション メカ娘バージョン

580コイン/月以上支援すると見ることができます

5

5

20260124【5枚】ブラウンチェック柄ドレスと眼鏡の女性

200コイン/月以上支援すると見ることができます

6

6

人間

全体公開

2

2

新機能チラ見せ!#7

100コイン/月以上支援すると見ることができます

13

13

和陰少女画像集ーPOP

全体公開

ポップな和陰少女の画像を集めました。

11

11

メカニックサムライガール

580コイン/月以上支援すると見ることができます

7

7

二人のJK187~193

100コイン/月以上支援すると見ることができます

12

12

えるたそ、紗霧、山田のシャフ度

全体公開

12

12

拳で語る

580コイン/月以上支援すると見ることができます

12

12

🚀 AI漫画制作:ステップバイステップ・メイキング

全体公開

Youtube、Geminiと“ちちぷい“のGemini3Proを使って、爆速で漫画を制作する方法です。 【Step 1】YouTubeから「神回」のネタを探す • ネタの選定: YouTubeのショート動画や切り抜き動画から、自分が「面白い!」「絵にしたい!」と思う神シーンを見つけます。 • ** Geminiへ共有:** その動画のURLをGeminiに貼り付け、内容を解析してもらいます。これがすべての始まりです。 • ポイント: 「この動画の12:00からのシーンを漫画にしたい」など、具体的な秒数を伝えると精度が爆上がりします。 【Step 2】音声入力で「脳内イメージ」を言語化する • Geminiで作ったプロンプトをそのまま使うと、漫画として読みにくかったり起承転結のすっきりしないものが上がってきます。 • 自由な指示: 「セリフはこうして」コマのサイズや位置といった微調整も、会話するように伝えてプロンプトに落とし込んでもらいます。 【Step 3】「ちちぷい」専用プロンプト(呪文)の完成 • 日本語直込みプロンプトの作成: Geminiが「ちちぷい」でそのまま使える日本語セリフ入りの英語プロンプトを作成します。 • 隠し味の追加: 4コマの構成、キャラの配置、効果音を、AIが描きやすい形式に整理します。 【Step 4】「ちちぷい」で生成&フィードバック • AIイラスト生成: 完成したプロンプトを「ちちぷい」に貼り付けて画像を生成します。 • 結果の確認: 出来上がった画像をGeminiに見せて、「ちゃんと隠れててOK!」や「もう少し表情を豊かに」とフィードバックし、納得のいく1枚(1ページ)を仕上げます。 ここに載せているものは、微調整前のボツイラストになります。 みこめっとのオチは、構図のいいものが出るまでガチャしました。 同一プロンプトでも結果ブレでテイストが変わります。

10

10

チャイナドレスのフ〇ーレン様とフ〇ルンちゃん

全体公開

6

6

混沌

全体公開